ИИ против шизофрении: почему алгоритмы не справляются с предсказанием терапии

Сегодня на ИИ возлагают большие надежды в персонализированной медицине. Идея заманчива: алгоритм проанализирует горы данных и подскажет, как конкретный человек отреагирует на конкретное лекарство. Но реальность, как выяснилось, куда капризнее. Йельские исследователи доказали, что такие модели могут быть гениальными в рамках лаборатории, где их создали, и абсолютно бесполезными за её стенами. Их точность падает до уровня случайного угадывания, стоит только сменить набор данных.

«Это серьезная проблема, — говорит соавтор работы Адам Чекроуд. — Наше исследование четко показывает: тестировать алгоритмы нужно не на одной выборке, а на многих». Проще говоря, нельзя судить о знаниях студента только по билетам, которые он зазубрил.

Иллюзия точности

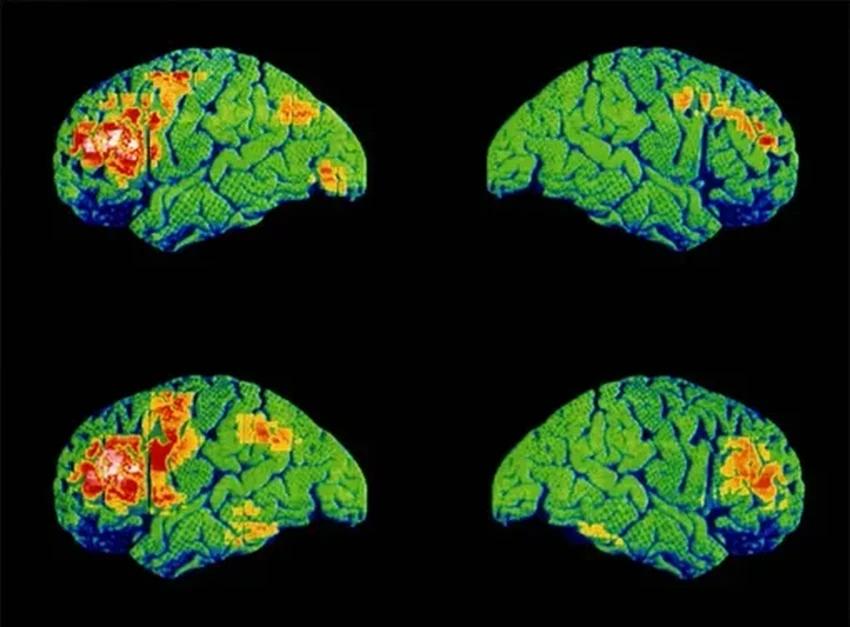

Ученые взяли под микроскоп популярный алгоритм, который часто используют для психиатрических прогнозов. Для анализа они привлекли данные пяти масштабных клинических испытаний антипсихотических препаратов. В них участвовало более полутора тысяч пациентов с диагнозом шизофрения со всего света — из Северной Америки, Азии, Европы и Африки.

Эти испытания, проходившие в 2000-х, фиксировали симптомы пациентов до начала приема лекарств и через четыре недели терапии. Исследователи обучили модель предсказывать, насколько улучшатся симптомы через месяц.

Первый этап был триумфальным: на данных, которые модель «зубрила», ее точность оказалась высокой. Прогнозы почти идеально совпадали с реальными исходами. Казалось бы, вот оно, будущее медицины.

А потом началась проверка на прочность. Модель учили на одной части данных из одного исследования и тестировали на другой части того же исследования. Потом учили на целом одном исследовании и пытались применить к совершенно другому. И здесь блестящий алгоритм дал сбой. Его предсказания стали хаотичными, почти случайными. Ученые повторили эксперимент с другим алгоритмом — результат был таким же печальным.

Проверка на дорогах

Авторы настаивают: модели клинического прогнозирования необходимо тестировать с куда большей тщательностью и на гораздо более широком спектре данных. Систематический обзор 308 подобных моделей в психиатрии показал удручающую картину: только каждая пятая проходила проверку на данных, отличных от учебных. Остальные жили в идеальном, но изолированном мирке.

«Ситуация очень напоминает историю с фармацевтическими испытаниями, — поясняет Чекроуд. — Многие препараты блестяще проходят первые тесты, а затем проваливаются на более широкой выборке. С алгоритмами та же история. Мы не можем один раз обучить модель, порадоваться и успокоиться. Нужна строгая, дисциплинированная и постоянная проверка на реальном, разнообразном мире». Ведь речь в конечном итоге идет не о данных, а о людях, верно?