Как ИИ учит язык, как ребёнок: только через видео и звук

Вспомните, как ребенок произносит первые слова. Никакой грамматики, лишь звуки, подражающие реальности. Но постепенно, снова и снова попадая в одни и те же ситуации и слыша одни и те же слова, мозг строит мост между зрением и слухом. Событие обретает имя, а слово — смысл. Просто, гениально и до боли знакомо.

Эта простая идея легла в основу масштабного проекта исследователей из MIT, Оксфорда, Google и Microsoft. Модель, названная DenseAV, была описана в научном препринте. И знаете, с чего все началось? С вовсе не детского лепета, а с одного очень выразительного... пингвина.

Откуда берется матерное слово в языке пингвинов

Ведущий автор работы Марк Гамильтон признается: «Ирония судьбы — нас вдохновил документальный фильм «Марш пингвинов». Там есть момент, где пингвин поскальзывается на льду и издает резкий, отрывистый крик. Когда видишь это, практически не остается сомнений: этот звук означает то самое английское слово из четырех букв». Звук и действие сливаются в абсолютно понятное сообщение, правда ведь?

Марш пингвинов. Трайлер

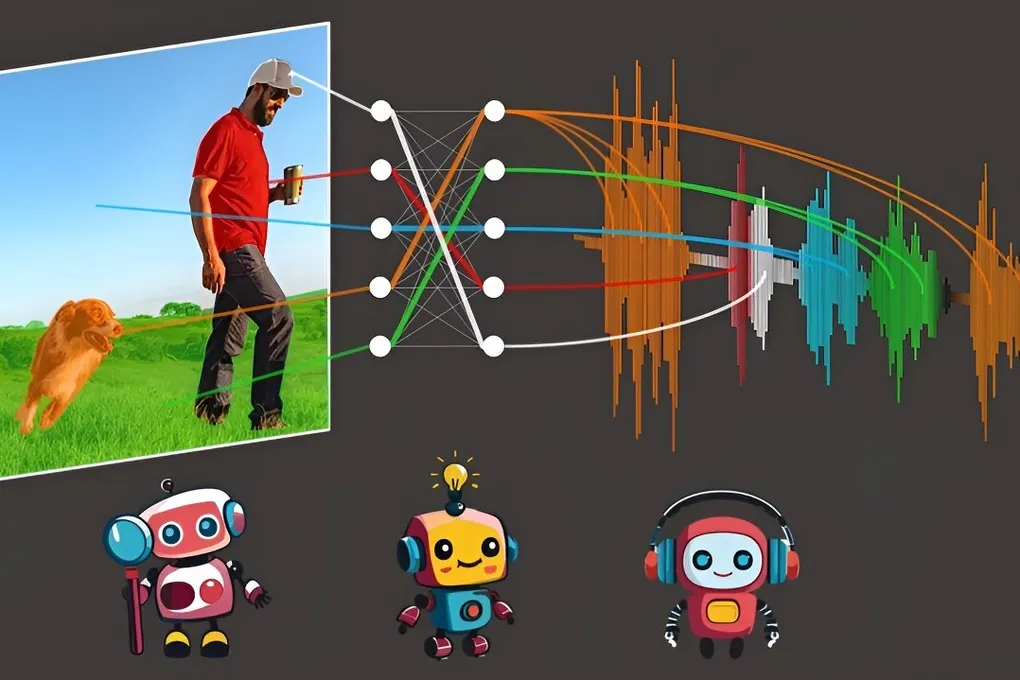

Для обучения модели ученые взяли AudioSet — огромную библиотеку из 2 миллионов неразмеченных видео с YouTube. Никаких подписей, никаких инструкций. Только «сырой» поток изображения и звука. Модель училась методом контрастного обучения, то есть самостоятельно находила связи между тем, что видит и что слышит. И она справилась. Начиная с чистого листа, как младенец, она научилась уверенно сопоставлять картинку со звуковым описанием и наоборот.

Это значит, что система может «озвучить» то, что видит на видео, и «увидеть» то, что слышит в аудио. Мост между мирами построен.

И неслучайно началось все с пингвина. Ученые смотрят далеко вперед: их цель — интерпретация языков животных. Представьте, что обучив модель на песнях горбатых китов и сопоставив их с подводной жизнью, мы наконец-то сможем понять, о чем они «говорят», проплывая в океанской темноте. Мы стоим на пороге возможности услышать мир так, как слышат его другие виды.