Как ИИ запоминает информацию: открыто удивительное сходство с мозгом человека

Междисциплинарная команда из Института фундаментальных наук сравнила процесс обучения в мозге с тем, как работает популярная архитектура «трансформер» — та самая, что лежит в основе ChatGPT и других языковых моделей. Фокус был на консолидации памяти, и результаты удивили даже самих исследователей.

Умная дверь в мозге и её цифровой двойник

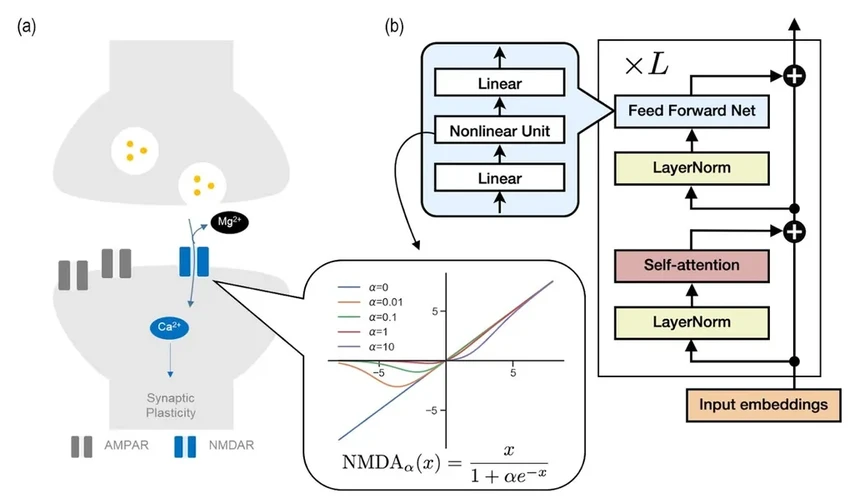

В нашем гиппокампе есть специальный рецептор — NMDA. Он работает как умная дверь с привратником. Возбуждающий сигнал (глутамат) пытается её открыть, но ион магния стоит на страже, блокируя проход. Только при определенных условиях «привратник» отходит, и информация поступает внутрь, превращаясь в долгосрочное воспоминание. Это хитрый и энергоэффективный биологический механизм.

И вот что поразительно: процесс управления вниманием в архитектуре трансформера, оказывается, работает очень похожим образом. Исследователи предположили, что можно напрямую сымитировать работу рецептора NMDA в коде. Они попробовали — и это сработало!

Известно, что в мозге низкий уровень магния ухудшает память. Ученые создали в модели цифровой аналог этого процесса, «настроив» параметры подобно рецептору. И что вы думаете? «Память» искусственной системы стала лучше. Получается, принцип, отточенный миллионами лет эволюции, может быть универсальным ключом к эффективному обучению. Разве это не элегантно?

Самое интересное, что создатели архитектуры трансформер не думали о нейробиологии. Они просто хотели сделать модель эффективнее. Но если сходство подтвердится дальнейшими исследованиями, это будет означать, что мы наткнулись на некий универсальный вычислительный принцип, пригодный и для кремния, и для нейронов. Это меняет правила игры.

«Это исследование делает важный шаг, позволяя нам глубже понять принципы работы мозга и разработать более совершенные системы», — говорит нейробиолог К. Джастин Ли.

Соавтор работы Ча Миёнг добавляет важный практический аспект: наш мозг работает на удивление экономно, в то время как большие языковые модели требуют гигантских вычислительных мощностей. Их открытие прокладывает путь к созданию недорогих и эффективных систем, которые учатся и запоминают информацию почти по-человечески.

Этот диалог между нейронаукой и компьютерными науками обещает не только более «умные» алгоритмы, но и новое понимание того, как устроено наше собственное мышление. Получается, изучая машины, мы в итоге лучше понимаем самих себя.