Как нейросеть учится читать мысли: распознавание действий по активности мозга

Чтобы создать по-настоящему работающий интерфейс «мозг-компьютер», нужно расшифровать, как электрические импульсы в нейронах превращаются в конкретные действия. Это и есть задача нейронного декодирования. Традиционно для этого в мозг вживляют электроды. Метод точен, но ужасно ограничен: электродов горстка, а нейронов — миллиарды. Получается смотреть лишь в замочную скважину.

Есть и другой подход — фМРТ. Он показывает активность целых областей мозга, но его разрешение оставляет желать лучшего, да и скорость обработки невысока. Настоящим прорывом стал метод визуализации кальция. Он позволяет, словно включив невидимый фонарь, увидеть свечение активных нейронов по всему мозгу в реальном времени. Правда, есть нюанс: метод требует генной модификации или введения красителей, поэтому на людях его не применишь. Зато для мышей — это идеальный инструмент, чтобы заглянуть в живой, работающий мозг.

Может ли алгоритм понять, о чем думает мышь?

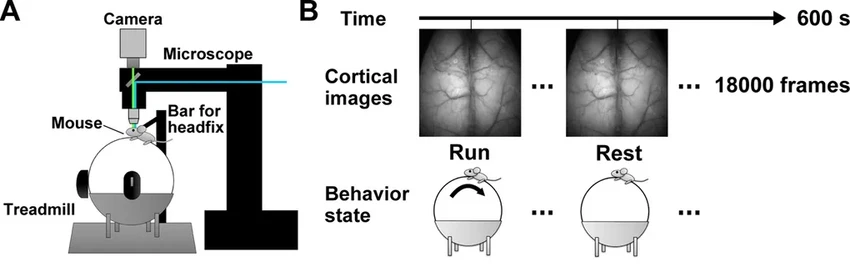

Именно этот метод и взяли на вооружение исследователи под руководством Такуми Тору. Они обучили нейронную сеть распознавать на снимках мозга, полученных методом визуализации кальция, паттерны активности. Проще говоря, они показали алгоритму «картину» мозга бегущей мыши и мозга мыши отдыхающей. И научили его их различать.

«Мы работаем с системами, которые визуализируют мозг в реальном времени, пока мышь свободно бегает в виртуальной реальности, — объясняет ведущий автор работы Аджиока Такехиро. — Мы используем глубокое обучение на неразмеченных данных со всей коры головного мозга. Это и позволило нам решить задачу декодирования».

Команда использовала сразу два алгоритма: один анализировал пространственную картинку (какие области светятся), а другой — временные закономерности (как это свечение меняется). Результат впечатляет: после обучения модель с точностью 95% определяла по одному лишь снимку, бежит подопытный зверек или бездельничает.

И это не требовало ручной обработки или поиска специальной «зоны движения» в мозге. Модель сама научилась выделять нужные сигналы из общего потока данных. Причем делала она это за 0,17 секунды — почти в реальном времени! Проверили на пяти разных мышах — алгоритм легко адаптировался к индивидуальным особенностям каждого мозга, не теряя в точности.

А дальше началось самое интересное. Ученые решили поиграть в «угадайку»: что будет, если мы начнем убирать часть данных со входа? Оказалось, что модель не только предсказывает поведение, но и сама показывает, какие данные для этого критически важны. Если после удаления какого-то участка снимка точность прогноза падала, значит, именно эта область несла ключевую информацию. Так исследователи составили карту «важных сигналов» в мозге мыши. Понимаете, насколько это круто? Мы не просто учим машину угадывать, мы заставляем ее рассказать, на что именно она смотрит.

«Эта работа закладывает основу для интерфейсов «мозг-машина», способных расшифровывать поведение практически в реальном времени с помощью неинвазивной визуализации», — резюмирует Такехиро. Фактически, мы становимся свидетелями рождения нового типа «переводчика» с языка нейронов на язык действий. И кто знает, что он сможет «перевести» в будущем.