Коллапс модели ИИ: почему машинам нельзя терять связь с человеком

Давайте вспомним, как вообще создают современные нейросети. Программисты задают архитектуру — математический скелет. А вот «мозги», то самое умение генерировать текст или картинки, появляются после долгой и мучительной тренировки на огромных массивах данных.

И вот ключевой момент: данные нужны не абы какие. Они должны быть качественными. Очень качественными. И их должно быть невероятно много.

Сколько надо данных

Цифры просто оглушают. Аарон Сносвелл приводит в пример GPT-3: для ее обучения понадобилось более 650 миллиардов английских слов. Это примерно в двести раз больше, чем вся англоязычная Википедия! Но знаете, что самое интересное? Это лишь верхушка айсберга. Чтобы получить этот отборный набор, OpenAI пришлось сначала выскрести из интернета почти в сто раз больше сырья, а потом выбросить 98% как непригодный мусор. Представляете масштаб этой цифровой уборки?

Гонка за данными — новая золотая лихорадка. Такие гиганты, как OpenAI, Google, Meta и Nvidia, неустанно прочесывают просторы сети, собирая терабайты текстов, картинок и кода. Но с 2022 года в игре появился новый фактор. Теперь люди массово выкладывают в сеть контент, который создан или обработан ИИ. И его становится все больше.

Естественно, у разработчиков возник соблазн: а что, если кормить новые модели только данными от старых моделей? Заманчиво, ведь это дешевле и проще с юридической точки зрения — не нужно платить авторам. И кто владеет правами на текст, написанный нейросетью? Как правило, компания-создатель.

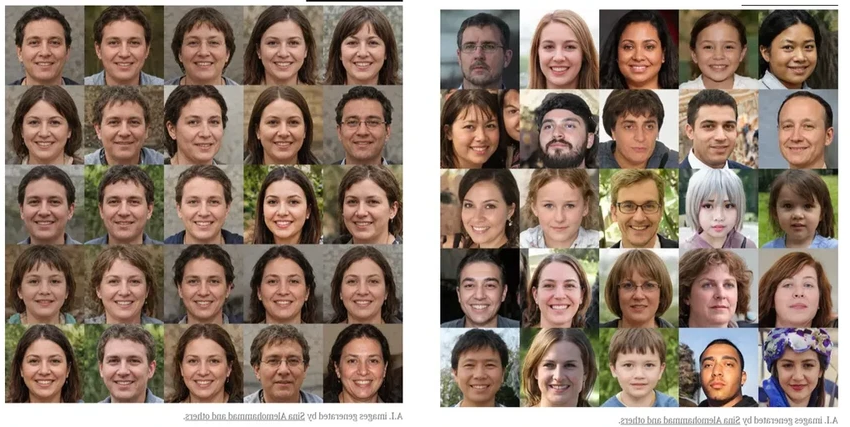

Однако исследования показали печальную тенденцию. ИИ, которого кормили исключительно синтетической пищей, с каждым поколением становился все «слабее умом». Он терял в качестве и разнообразии ответов. Это напоминает цифровой инбридинг — близкородственное скрещивание, ведущее к вырождению. Неужели мы действительно можем «испортить породу» машинного интеллекта?

Под «качеством» здесь понимают не только полезность, но и безопасность, и честность модели. А «разнообразие» — это вариативность реакций, отражение разных культур и точек зрения. Без человеческой подпитки все это быстро исчезает.

Может, просто отфильтровывать контент от ИИ? — спросите вы. Увы, это не панацея. Компании уже тратят колоссальные ресурсы на чистку данных. Один инсайдер рассказывал, что иногда отбрасывается до 90% собранного материала! С ростом объема синтетического контента эта задача станет только сложнее и дороже. В долгосрочной перспективе отличить творение человека от творения машины будет практически невозможно. Гонка вооружений, в которой у ИИ скоро будет преимущество.

Вывод исследований однозначен: без человеческих данных нам не обойтись. Они — тот самый «изюм» в булке, тот самый «человеческий дух», без которого ИИ становится просто сложным статистическим автоматом.

Мы идем к катастрофе?

Есть тревожные звоночки. Например, в документации к GPT-4 упоминается «беспрецедентное» количество людей, занятых подготовкой данных. Похоже, добыча качественного сырья становится самой сложной частью работы. А что, если оно на исходе? Некоторые аналитики полагают, что запасы человеческих текстов в интернете могут закончиться уже к 2026 году. Пугающая мысль, правда?

Это, вероятно, и объясняет лихорадочные попытки OpenAI и других компаний заключить эксклюзивные сделки с архивами Shutterstock, Associated Press или NewsCorp. Они скупают не тронутые ИИ «месторождения» человеческого творчества.

Но, пожалуй, не стоит рисовать на стенах картины тотального коллапса. Большинство исследований рассматривают экстремальный сценарий — полную замену человеческих данных синтетическими. В реальности же они будут смешиваться, что снижает риски. Кроме того, будущее — это не одна монопольная модель, а целая экосистема разных ИИ, что тоже добавит устойчивости. Вот вам и аргумент в пользу здоровой конкуренции и против монополий в этой сфере.

Реальные опасения

А вот настоящая опасность, на мой взгляд, лежит в другой плоскости. Даже если ИИ не погубит сам себя, он может «отравить» нашу цифровую среду обитания — тот самый «живой» интернет, созданный людьми для людей.

Взгляните на StackOverflow, легендарный ресурс для программистов. Через год после выхода ChatGPT активность там упала на 16%. ИИ-помощники, получается, разъедают человеческое сообщество, снижая потребность в общении и взаимопомощи. Грустно, согласитесь.

Другая напасть — «фермы» контента, где ИИ штампует тонны бездушных статей для кликбейта. Найти среди этого потока что-то настоящее, созданное с мыслью и эмоцией, становится все труднее. Водяные знаки и маркировка — лишь полумеры в этой войне за аутентичность.

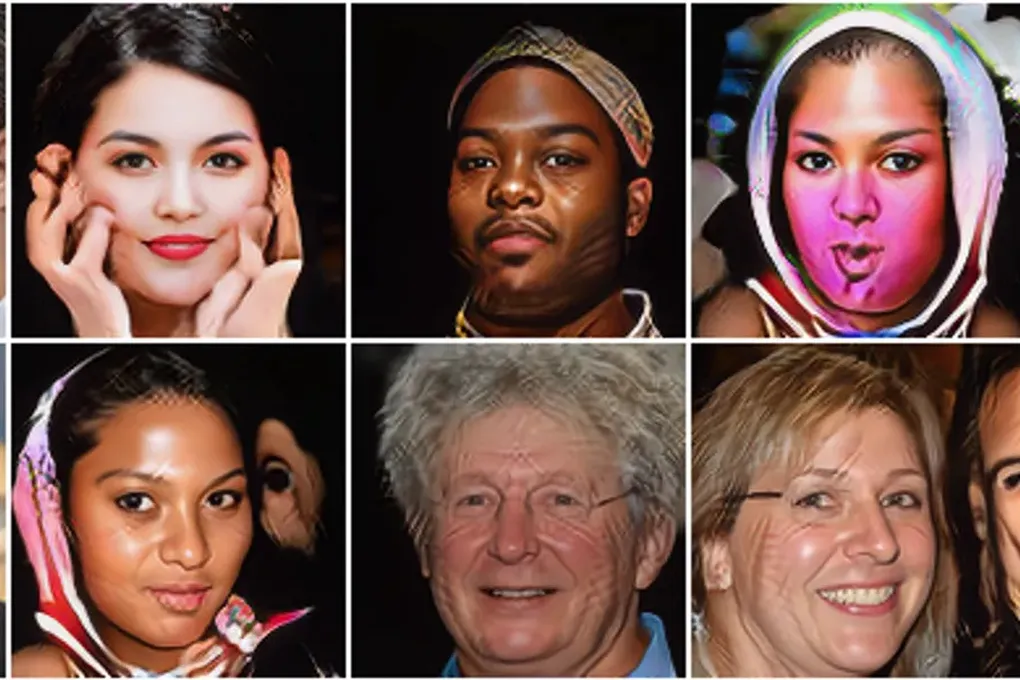

И есть еще один, глубоко культурный риск. Если ИИ будет систематически выдавать усредненный, стерильный контент, мы можем потерять социокультурное разнообразие. Целые пласты человеческого опыта, взгляды меньшинств, уникальные культурные коды — все это рискует раствориться в море синтетической «нормы».

Так что, защищая человеческие данные, мы защищаем не только будущее ИИ, но и будущее нашего собственного, человеческого цифрового мира. И это, пожалуй, куда важнее гипотетического «коллапса модели».