Microsoft Phi-2: как маленькая ИИ-модель учится по учебникам и удивляет

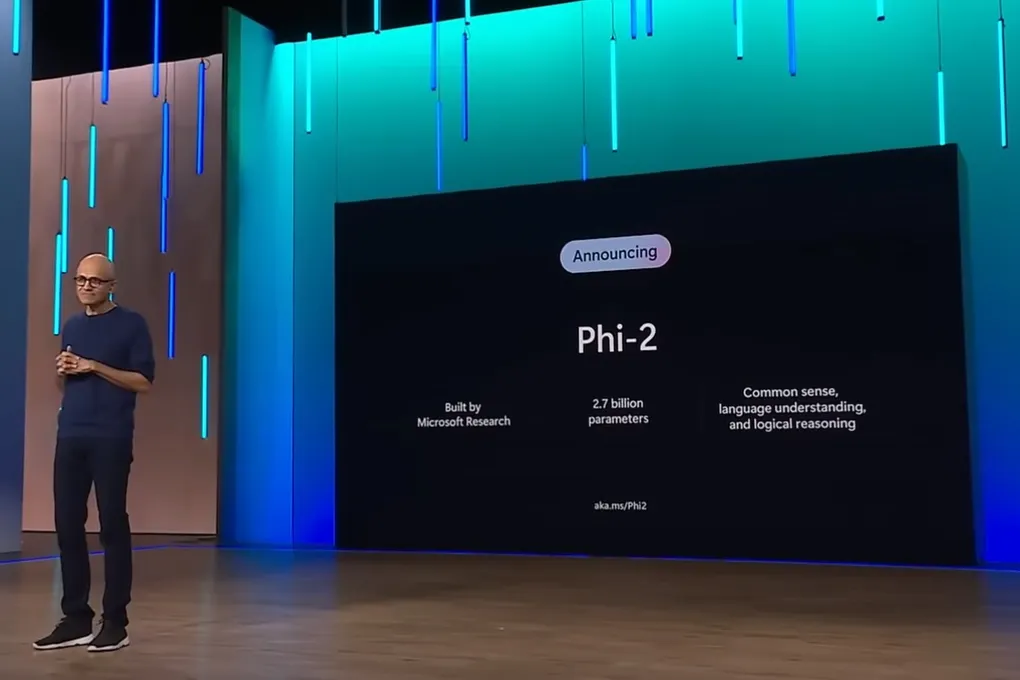

История семейства Phi началась с модели на 1,3 миллиарда параметров, которая удивила всех своими навыками в написании кода на Python. Потом появилась Phi-1.5, которая научилась лучше понимать смысл текста. А теперь её наследница, Phi-2, показывает результаты, сопоставимые с моделями впятеро больше. И она уже доступна для экспериментов в Azure AI Studio.

Получается, что размер — не главное? Похоже, да. Главное — качество «образования».

Маленькие, да удаленькие: в чем фокус?

Конечно, монстры вроде GPT или Gemini произвели революцию. Но их аппетиты к вычислительной мощи огромны. А что, если можно добиться сравнимых результатов, будто сжав весь этот интеллект в крошечный флеш-накопитель?

Именно этим путем пошла команда Microsoft Research. Их выводы ломают стереотипы:

- Всё решают данные. Старая истина, но здесь её довели до абсолюта. Phi-2 кормили не случайными текстами из сети, а тщательно отобранными учебниками. Разработчики буквально заявляют: «Учебников достаточно». Кроме того, модель обучали на данных, развивающих здравый смысл и общие знания — от основ науки до понимания, что думают другие люди. Качество, а не количество — вот девиз.

- Искусство эффективного масштабирования. Инженеры нашли способы заставить каждый новый параметр работать на максимум. Резкий скачок в возможностях между Phi-1.5 и Phi-2 — лучшее тому доказательство. Это как научить компактный двигатель выдавать мощность гоночного болида.

Может ли ИИ учиться в школе? Проверили

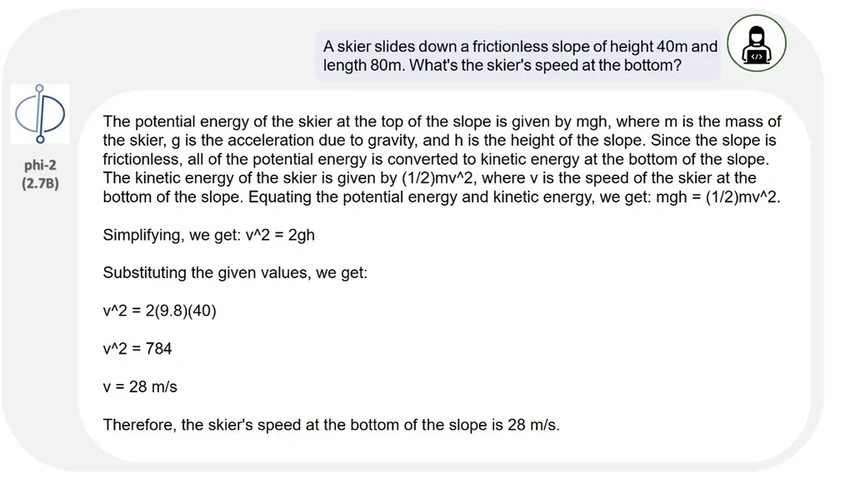

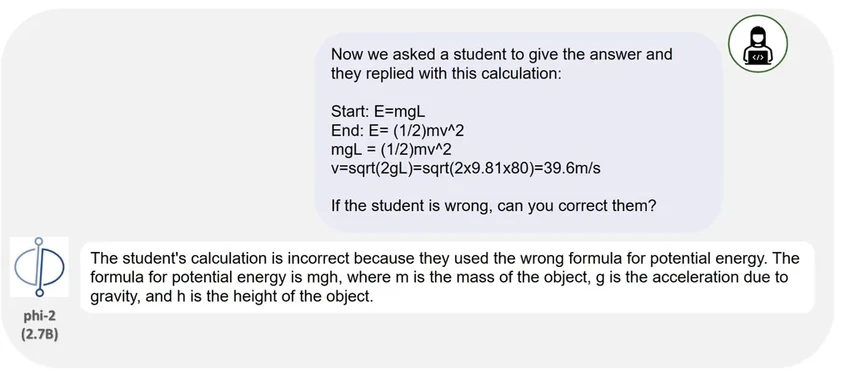

Чтобы показать возможности Phi-2, разработчики дали ей школьные задачки. И она справилась. В одном случае модель самостоятельно решила задачу по физике, в другом — нашла ошибку в готовом решении. Неплохо для «ученика» размером с небольшую программу, правда?