Может ли ИИ сомневаться? Как нейросеть учат принимать решения по-человечески

Обычные нейронные сети стремятся к однозначности: одинаковый вход — всегда одинаковый выход. Исследователи же попытались наделить алгоритм очень человеческим свойством — внутренней оценкой собственной правоты.

В журнале Nature Human Behaviour они представили модель RTNet, которая демонстрирует признаки принятия решений, удивительно похожие на наши.

«Нейросеть выдает решение, но не говорит, насколько она в нем уверена, — объясняет соавтор работы Фаршид Рафии. — А человек почти никогда не бывает уверен на все сто процентов. Это фундаментальное различие».

Большие языковые модели часто «галлюцинируют»: на неизвестный вопрос они с той же безмятежной уверенностью сочиняют ответ, что и на простой. Человек же в такой ситуации скорее скажет: «Не знаю». Ключевой недостаток ИИ — отсутствие здоровых сомнений. Создание более «человечной» нейросети могло бы резко сократить поток таких выдумок.

Сомневающаяся нейросеть

Команда обучила свою модель на классическом наборе рукописных цифр MNIST. Сначала проверили ее на чистых данных, а затем добавили шум, сделав цифры едва различимыми. Ту же усложненную задачу дали группе студентов-добровольцев.

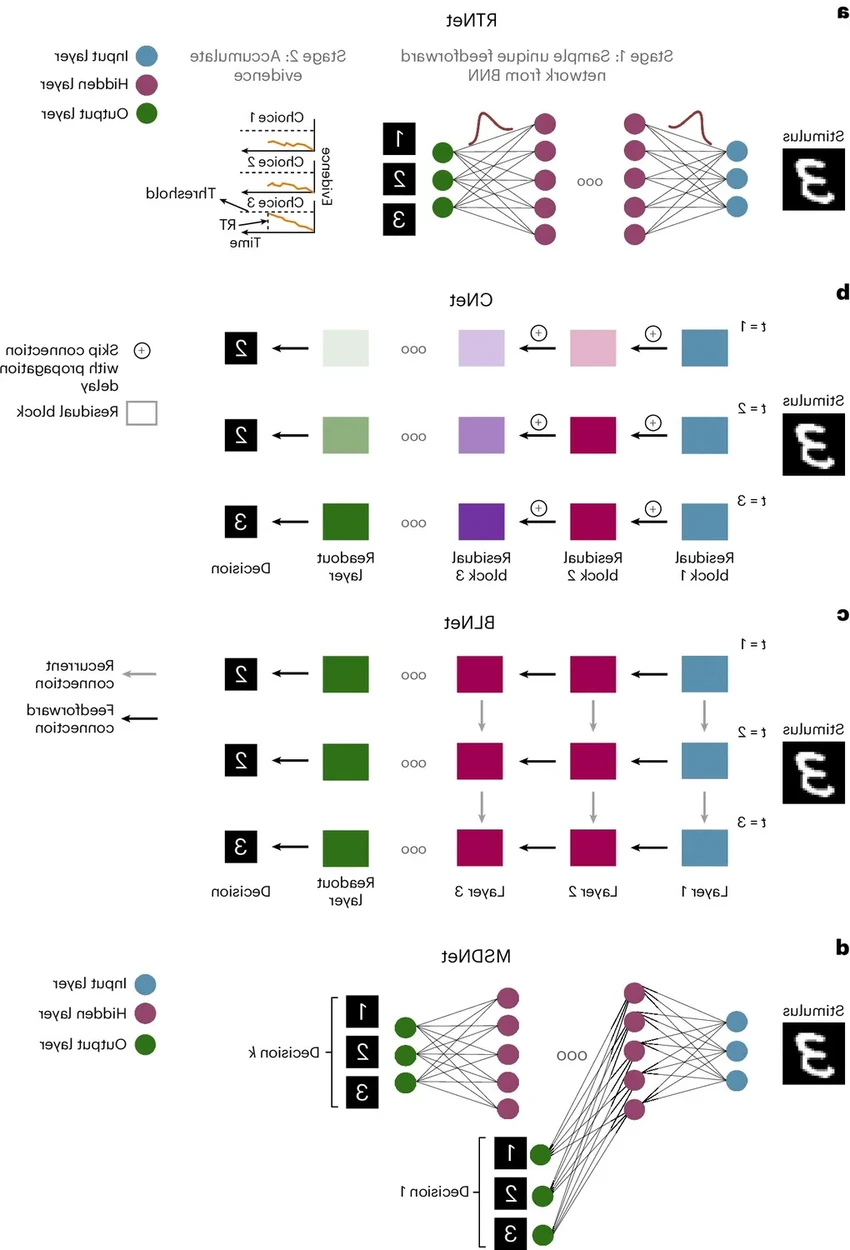

Архитектура RTNet состоит из двух ключевых частей. Первая — байесовская нейронная сеть (BNN), которая вычисляет вероятность правильности каждого возможного ответа. Вторая — процесс накопления свидетельств: система собирает «улики» в пользу разных вариантов. Эти свидетельства могут колебаться, поддерживая то один, то другой ответ. Как только для какого-то варианта набирается достаточный вес «уверенности», процесс останавливается — решение принято. Очень похоже на наше внутреннее «ага!»

Результаты сравнили с человеческими. Шестьдесят студентов просматривали те же зашумленные цифры и оценивали свою уверенность. Оказалось, что точность, время реакции и даже профиль уверенности у RTNet и людей оказались поразительно схожими.

Модель также обошла другие нейросети в тестах на скорость и точность, потому что переняла еще одну человеческую черту: она, как и мы, чувствует себя увереннее, когда принимает правильное решение. «Даже без специального обучения модель автоматически выучила эту корреляцию», — отмечает Рафии.

Ученые планируют испытать свою «сомневающуюся» архитектуру на более сложных и разнообразных данных. Их цель — интегрировать этот подход в другие нейросети, чтобы снизить количество галлюцинаций. Кто знает, возможно, следующее поколение ИИ будет не столько всезнающим, сколько более осознанным в своих незнаниях.