Нейросети учатся забывать: прорыв для непрерывного обучения ИИ

Группа исследователей из Канады сделала важное открытие: непрерывное обучение на потоке новых данных для стандартных нейросетей заканчивается крахом. Их производительность падает, ответы становятся шаблонными. Но решение нашлось элегантное и, если вдуматься, очень человеческое. Чтобы учиться без остановки, системе нужно периодически забывать часть выученного. Результаты этой работы опубликованы в авторитетном журнале Nature.

За последние годы ИИ прочно вошел в нашу жизнь. Большие языковые модели ведут с нами почти осмысленные диалоги. Но у них есть фундаментальный недостаток: они застывают в момент своего создания. Модель не может становиться умнее в процессе общения с вами, учиться на ваших вопросах и ошибках. Она просто воспроизводит то, что выучила когда-то. Разве это интеллект?

Современный машинный обучение держится на трех китах: искусственные нейронные сети, методы глубокого обучения и алгоритм обратного распространения ошибки.

И применяются они почти всегда в два четких этапа. Сначала идет фаза обучения, когда «веса» сети (ее внутренние настройки) активно меняются. А потом — фаза эксплуатации, когда все эти настройки замораживаются. Похоже на выпускника вуза, который после диплома больше никогда не открывает учебник. Мы-то с вами учимся иначе — постоянно, на всем, что видим и слышим.

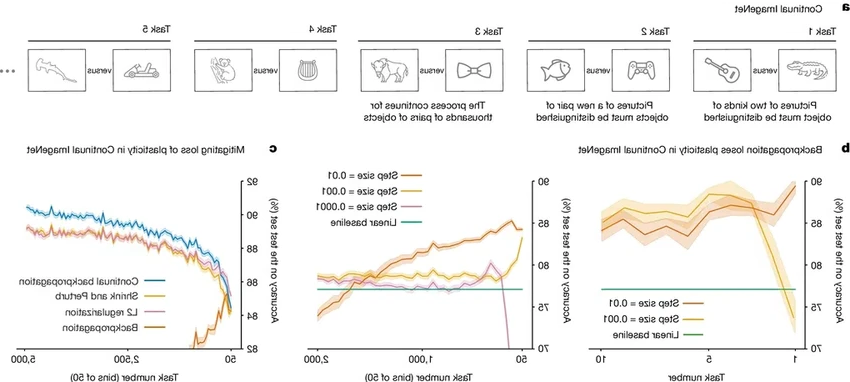

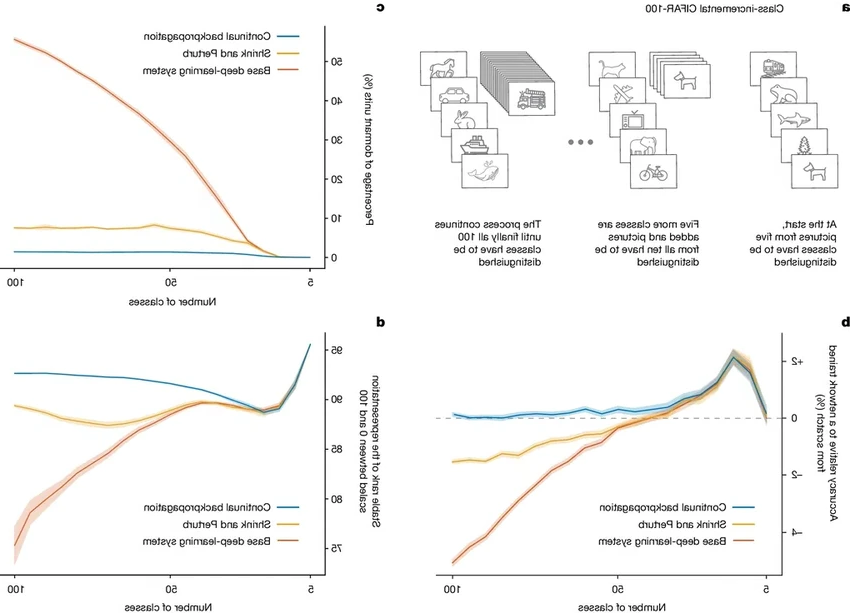

Долгое время было неясно, а что будет, если поставить нейросеть в такие же «человеческие» условия — заставить ее учиться непрерывно, без пауз? Канадские ученые проверили. Оказалось, что при стандартных подходах модели быстро теряют пластичность — ту самую гибкость, которая позволяет усваивать новое. Их ответы вырождаются, наступает переобучение. Этот эффект ученые ярко продемонстрировали на классическом наборе изображений ImageNet.

Но они нашли неожиданный выход. Пластичность можно сохранить, если постоянно вносить в сеть элемент разнообразия, легкий хаос.

Ученые разработали метод, который назвали алгоритмом непрерывного обратного распространения. Его суть проста и гениальна: небольшая часть самых редко используемых параметров сети периодически обнуляется, возвращается к случайным начальным значениям. Фактически, нейросеть забывает какую-то часть информации. Как ни странно, это постоянное легкое забывание и позволяет ей учиться бесконечно, не скатываясь в деградацию. Прямо как нам иногда нужно расчистить стол в голове, чтобы положить туда новые знания.