Новые языковые модели ИИ: как ученые снизили энергопотребление, скопировав мозг

Группа программистов из Калифорнийского университета вместе с коллегами из Университета Сучжоу и компании LuxiTec придумали, как запускать языковые модели, полностью отказавшись от матричного умножения (MatMul). Свои выводы они выложили на сервер препринтов arXiv.

Мощность моделей вроде ChatGPT растет как на дрожжах, а вместе с ней взлетают и аппетиты к вычислительным ресурсам. Обычно работа LLM строится на матричном умножении: входные данные комбинируются с весами в нейросетях, чтобы выдать наиболее вероятный ответ на ваш вопрос. Это основа основ.

Даже с использованием графических процессоров (GPU), заточенных под параллельные вычисления, матричное умножение оставалось узким горлышком, тормозящим развитие LLM. Можно сказать, главной головной болью инженеров.

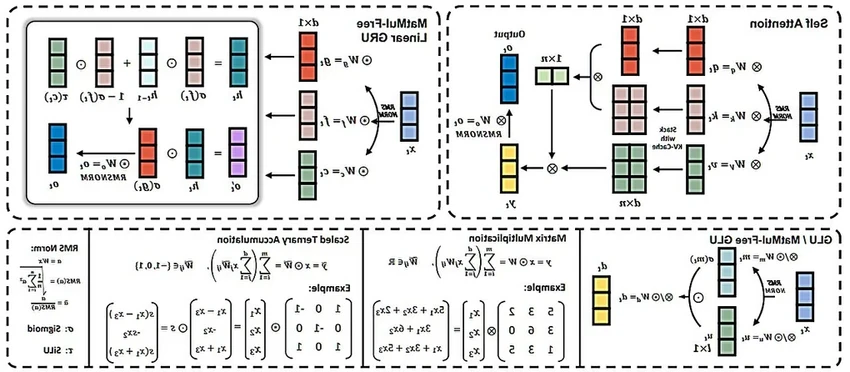

Новый подход переворачивает эту парадигму с ног на голову. Вместо привычных 16-битных чисел с плавающей точкой исследователи перешли на тернарную систему значений {-1, 0, 1}. По сути, они заменили сложные арифметические операции на простые логические.

Тесты обнадеживают: система показывает производительность, сравнимую с современными моделями, но при этом требует куда меньше вычислительной мощности и, соответственно, электроэнергии. Неплохой компромисс, правда?

Что нас ждет: перспективы и подводные камни

Снижение требований к «железу» может демократизировать доступ к мощным языковым моделям. А падение энергопотребления — серьезно уменьшить экологический след от работы ИИ, что в наше время уже не просто техническая, а этическая задача.

Вполне вероятно, что большим моделям с такой архитектурой больше не понадобятся топовые GPU. Тогда их можно будет запускать на множестве простых и дешевых устройств — представьте себе полноценный ИИ-ассистент прямо в вашем смартфоне, работающий автономно.

Перспективы, конечно, захватывающие. Но вот воплощение этой идеи в жизнь, скорее всего, потребует и новых специализированных процессоров. А это путь небыстрый, полный проб и ошибок. Готово ли индустрия к такому шагу? Время покажет.