От динозавров до гениев: что движет прогрессом языковых ИИ

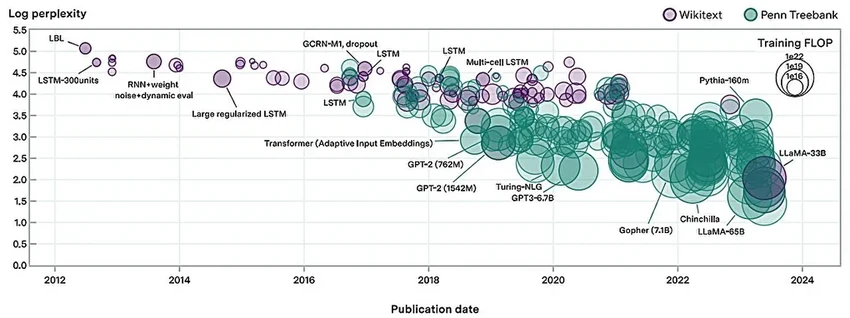

Вспомните 2012 год. Языковые модели того времени — это были робкие рекуррентные сеточки, с трудом справлявшиеся с парой связных фраз. А теперь взгляните на современность: GPT-4 запросто обходит среднего американского абитуриента по тесту SAT. Как мы проделали этот путь так стремительно? Неужели всё дело лишь в том, что мы стали вкладывать больше денег в «железо»?

Исследователи из Epoch, MIT FutureTech и Северо-Восточного университета задались этим вопросом всерьез. Они разделили движущие силы прогресса на две категории: грубую вычислительную силу и изящные алгоритмические инновации. И стали сравнивать.

Их выводы поражают: благодаря одному только совершенствованию алгоритмов, объем вычислений, нужный для обучения модели до одного и того же уровня, сокращается вдвое… каждые восемь месяцев! Это же безумный темп.

«Это ключ к пониманию не только прошлого, но и будущего языковых моделей, — говорит Энсон Хо, один из авторов работы. — Да, масштабирование вычислений критически важно, но это лишь часть картины. Если игнорировать прогресс в алгоритмах, вы просто не увидите всей мозаики».

От эпохи «динозавров» (2012 год) до наших дней (2024 год)

В основе их метода — «нейронные законы масштабирования»: сложные формулы, предсказывающие, на что способна модель при заданных вычислительных ресурсах. Проанализировав 231 модель с 2012 года, ученые создали модифицированную версию закона, которая учитывает не только мощь компьютеров, но и красоту алгоритмической мысли.

И что же? Оказалось, что на сегодняшний день масштабирование мощностей всё-таки было важнее. Более того, относительная значимость алгоритмических улучшений со временем… снижалась. Звучит грустно для теоретиков, но не спешите с выводами.

«Это не значит, что инновации замедлились, — поясняет соавтор Тамай Бесироглу. — Скорее, алгоритмический прогресс идет устойчивым шагом, а вот объем вычислений взлетел как ракета. На его фоне вклад алгоритмов и кажется меньшим».

Цифры подтверждают: рост вычислительных ресурсов ускоряется, а вот скорость алгоритмических улучшений остается постоянной. Просто один фактор временно затмил другой своим денежным блеском.

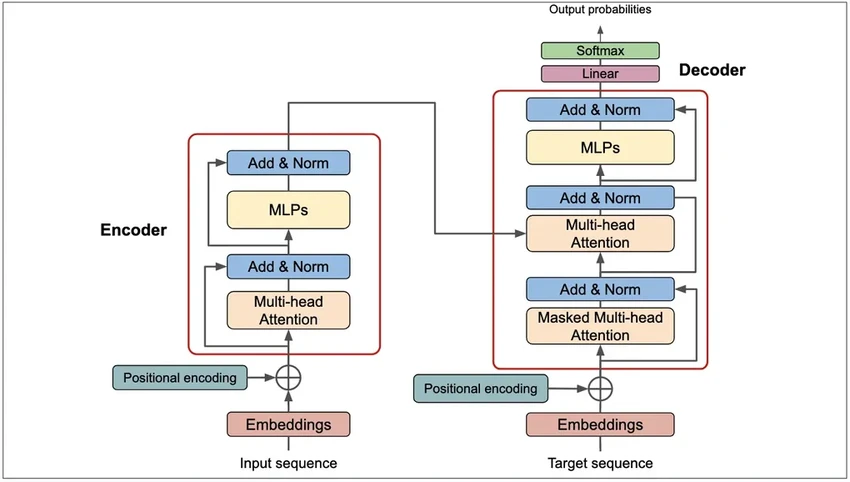

Трансформер

Ученые решили оценить вклад настоящей революции — архитектуры Transformer, появившейся в 2017 году. И знаете, насколько она была прорывной? Её эффективность эквивалентна почти двум годам стандартного алгоритмического прогресса! Одно изобретение — и такой рывок. Заставляет задуматься, какая следующая идея перевернет всё с ног на голову.

Конечно, у исследования есть границы. Как отмечает Хо, их метод не измеряет прогресс в решении таких задач, как программирование или математика, где языковые модели тоже блистают.

Предсказание будущего

Но главная ценность этой работы — в ее взгляде в завтрашний день. Понимание баланса сил помогает предугадать траекторию развития ИИ, а это уже вопрос политики, безопасности и доступности технологий.

«Эта работа — об демократизации ИИ, — говорит Нил Томпсон из MIT FutureTech. — Благодаря ежегодному удвоению алгоритмической эффективности, уровни производительности, которые вчера были доступны лишь гигантам вроде Google, завтра станут инструментом для маленьких стартапов и исследователей».

Лукас Финнведен из Open Philanthropy, не участвовавший в исследовании, добавляет: «Эта работа касается самого главного: что нас ждет? Результаты ясно показывают: пока бюджеты на вычисления растут в четыре раза в год, они остаются главным локомотивом прогресса. Но это не вечно. Инвестиционный пузырь может сдуться, безумные темпы роста — замедлиться. И тогда на авансцену вновь выйдут те, кто придумывает гениальные алгоритмы. Именно они будут определять будущее, когда деньги перестанут литься рекой».