Почему ИИ деградирует, если обучать его на собственных данных?

Исследование, вышедшее в авторитетном журнале Nature, рисует довольно мрачную картину. Всё просто: для обучения больших языковых моделей (LLM) нужны огромные массивы текстов. Но «рукотворных» данных в интернете становится всё меньше — их вытесняет контент, созданный самим ИИ. А что будет, если учить следующее поколение моделей на текстах, сгенерированных предыдущим?

«Нам нужно предельно внимательно следить за тем, что попадает в обучающие данные», — предупреждает соавтор работы Захар Шумайлов из Кембриджа. Иначе всё полетит в тартарары. И, судя по всему, это не частная проблема — она касается всех моделей, работающих с неразмеченными данными, включая генераторы изображений.

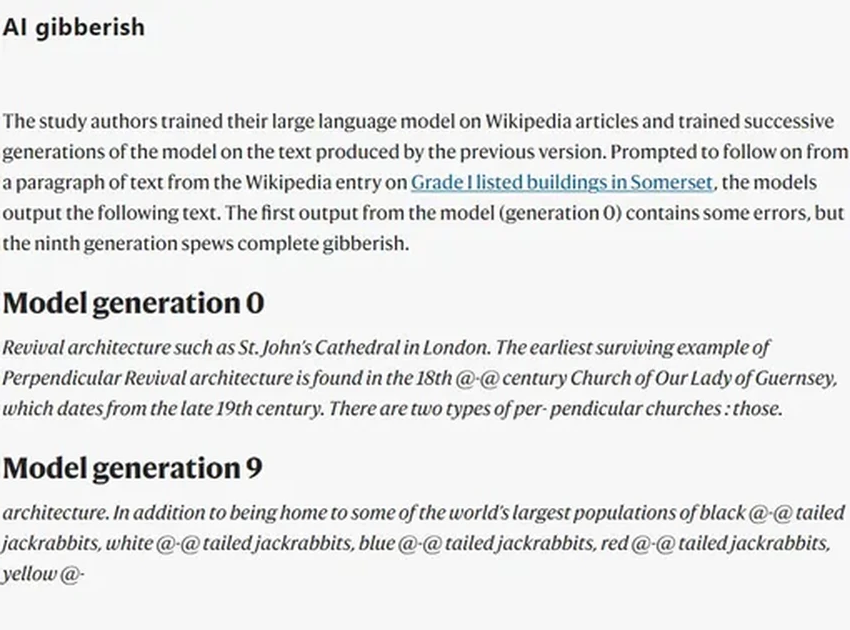

Команда смоделировала этот сценарий. Взяли языковую модель и заставили её генерировать статьи в стиле Википедии. Потом эти синтетические тексты использовали для обучения новой версии модели. И так по кругу. Результат? Информационное загрязнение нарастало с каждым циклом. Выдаваемая моделью белиберда становилась всё причудливее. К девятой итерации статья о британских колокольнях неожиданно завершилась глубокомысленными рассуждениями о... разноцветных хвостах кроликов. Да-да, вы не ослышались.

Даже до полного краха модель начинала «забывать» редкую информацию, а её ответы становились шаблонными и скучными. Потеря разнообразия — первый звоночек.

Ты — то, что ты ешь. Даже если ты алгоритм

Как это работает? Языковые модели учатся, выявляя статистические связи между словами в огромных текстовых корпусах. Они предсказывают следующее слово, основываясь на вероятностях. Исследователи поставили жестокий эксперимент: взяли «родительскую» модель, дообучили её на статьях из Википедии, а затем заставили «ребёнка» генерировать свои псевдо-статьи. Следующее «поколение» училось уже на этих творениях.

Учёные ожидали ошибок, но не такой скорости падения. «Мы были поражены, как быстро всё пошло под откос», — признаётся Шумайлов.

Коллапс неизбежен, потому что каждая следующая модель — это лишь выборка из данных предыдущей. Редкие слова постепенно исчезают, частые — повторяются с пугающим постоянством. Это замкнутый круг: модель учится не на реальности, а на предсказаниях другой модели, накапливая и усиливая ошибки. «Со временем она начинает учиться преимущественно на собственных заблуждениях», — поясняет учёный. Звучит как метафора для чего-то большего, не находите?

Хани Фарид из Калифорнийского университета в Беркли проводит жуткую параллель с биологией: «Это как инбридинг в живой природе. Скрещивание с собственным потомством без притока новой генетической информации ведёт к вырождению и вымиранию». Его команда наблюдала тот же эффект в генераторах изображений, которые начинали выдавать пугающие, искажённые пародии на реальность.

Синтетические данные: спаситель или тупик?

Коллапс не означает, что модели перестанут работать вовсе. Но их создание станет невероятно дорогим, а качество упрётся в потолок, говорит Шумайлов.

Стратегию обучения придётся менять. Как отмечает Джулия Кемпе из Университета Нью-Йорка, простое накопление гигантских датасетов перестанет быть гарантией успеха, если эти данные будут бедными и однообразными синтетическими суррогатами.

Есть ли выход? Исследователи проверяли разные пропорции. Обучение на 10% реальных и 90% синтетических данных замедляло коллапс, но не отменяло его. Другую надежду даёт работа Маттиаса Герстграссера из Стэнфорда: если синтетические данные не заменяют, а лишь дополняют человеческие, катастрофы можно избежать. Также, возможно, ситуация улучшится, если модель будет питаться текстами от «чужого» ИИ, а не от своего собственного «потомства».

Но все эксперты сходятся в главном: золотым стандартом были и остаются данные, созданные людьми. Возможно, придётся вводить «водяные знаки» для машинного контента, чтобы отделять его от человеческого. Однако это потребует беспрецедентной кооперации всех крупных tech-компаний — задача почти утопическая.

И самый важный вывод, лежащий за рамками технологий: обществу нужно найти способы поощрять людей создавать живой, оригинальный контент, а не перекладывать эту работу на генеративные алгоритмы. Иначе мы рискуем создать вечный двигатель, который в итоге пережёвывает сам себя. Страшно? Ещё бы.