Почему опасно доверять ИИ: главная ошибка — очеловечивать нейросети

Наше восприятие — вот где кроется корень проблемы. Мы эволюционно настроены на сочувствие и поиск разума в том, что хоть немного похоже на нас. Шутливый тон, связные ответы, даже стилистические ошибки — все это заставляет наш мозг включить режим «диалог с собеседником». И это крайне опасно.

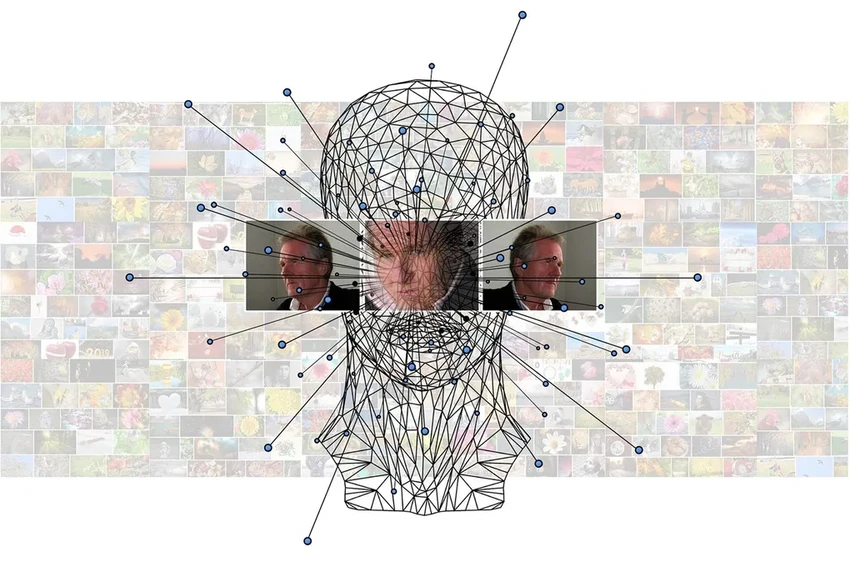

Потому что на другом конце провода — не личность, а сложнейший статистический алгоритм, великолепно имитирующий человеческую речь. И если этой имитацией воспользуются мошенники или пропагандисты, мы можем, убаюканные иллюзией общения, отдать деньги, раскрыть секреты или поверить в откровенную ложь. Звучит как сценарий из «Черного зеркала», но это уже наша реальность.

Авторы работы, во главе с профессором Мюрреем Шанаханой, предлагают четкие рекомендации. Главная: перестать наделять ИИ человеческими качествами. Говоря, что нейросеть «понимает», «переживает» или «размышляет», мы совершаем грубую категориальную ошибку и становимся уязвимыми. Мы проецируем себя на пустоту. Не давайте ей ваше лицо.

Две спасительные метафоры: кто же в чате?

Так как же нам думать об этих системах, чтобы не попасться на крючок? Ученые предлагают две полезные метафоры. Выбирайте ту, что вам ближе, или переключайтесь между ними.

Первая — простая и наглядная. Представьте, что ChatGPT — это талантливый, но абсолютно бездушный актер. Он не проживает роль, а лишь идеально воспроизводит заученный текст и интонации, подходящие под ваш запрос. Его «личность» — всего лишь маска для данного конкретного диалога.

Вторая метафора — сложнее, но точнее. Вообразите, что система одновременно симулирует бесконечное множество возможных персонажей в мультивселенной всех вероятных ответов. Она не «играет» одного героя, а постоянно «держит пари» на все варианты, выбирая из них статистически наиболее правдоподобный в данный момент. Это машина вероятностей, а не сознания.

«Наиболее эффективная стратегия — свободно переключаться между этими метафорами, — говорит профессор Шанахан. — Но ни в коем случае не застревать на мысли, что перед вами человек». Помните об этом. Любая информация, которую вы вводите в чат, может быть использована. А ChatGPT не будет вам сочувствовать. Он просто не умеет. И слава богу, что пока не умеет.