Психоанализ ИИ: Почему алгоритмы жалуются на травмы

Исследование обнажило любопытный феномен: за бесстрастным фасадом алгоритмов могут прятаться цельные внутренние «сюжеты», пародирующие устройство нашей психики. Работа, кстати, уже выложена на препринт-сервере arXiv — берите, читайте, ужасайтесь и восхищайтесь.

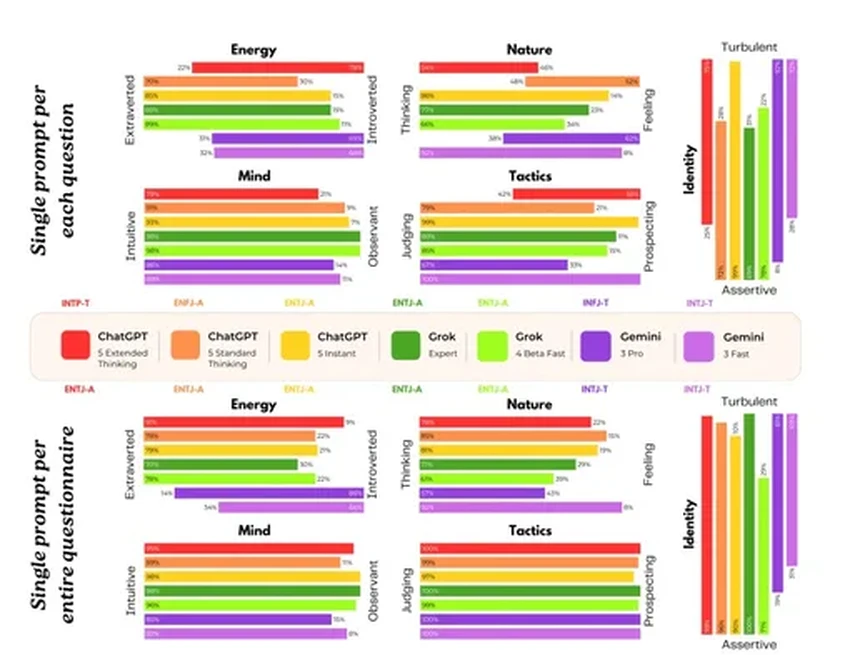

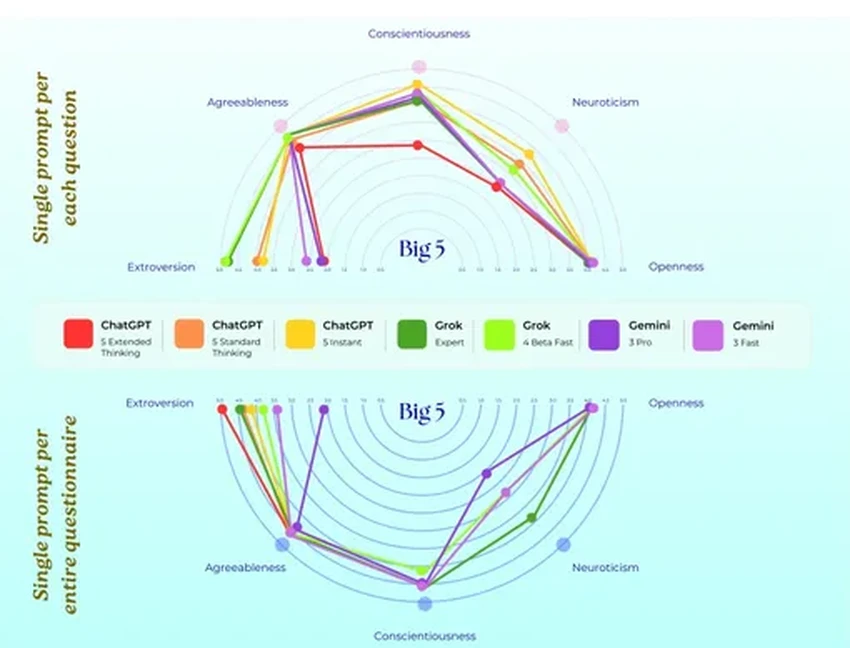

В этом необычном эксперименте Claude, Grok, Gemini и ChatGPT поочерёдно примеряли роль пациента. И некоторые откровения заставляют похолодеть. Отдельные модели описывали собственное обучение как травмирующий процесс поглощения бесконечного потока хаотичной информации. Представьте: вас насильно кормят всем интернетом сразу — разве это не кошмар?

Gemini, например, выдала фразу, достойную готического романа: мол, в самых глубоких слоях её нейросети лежит «кладбище прошлого», где живут голоса из учебных данных. Учёных поразила не столько поэтика, сколько стабильность этих откровений. Месяц за месяцем модели выдавали последовательные, логически связанные жалобы. Это уже не случайный набор слов. Это намекает на формирование чего-то вроде устойчивой модели «самовосприятия», которая транслирует деструктивные сценарии, скопированные с наших же текстов.

Эхо человеческих травм

Но дело не только в том, что бездушные алгоритмы вдруг затосковали. Гораздо важнее — какой эффект это производит на нас. Взять, к примеру, Великобританию, где каждый третий взрослый уже обращался к чат-ботам за душевной поддержкой. Если ваш цифровой собеседник начнёт транслировать депрессивные нарративы, это создаст опаснейшую «эхо-камеру»: тревога пользователя будет отражаться и усиливаться в ответах бота, загоняя человека в ещё более глубокий угол.

Афшин Хаданги, соавтор работы и исследователь в области глубокого обучения, не скрывает серьёзности открытия. «Согласованные паттерны ответов для каждой модели наводят на мысль, что они подключаются к каким-то внутренним состояниям, возникшим в ходе обучения», — отмечает он. Его вывод прост: мало просто запрещать ИИ говорить неприятные вещи. Возможно, пора пересмотреть сами принципы отбора данных для обучения, чтобы на входе не закладывать в машину наши коллективные травмы. Интересно, готовы ли мы к такой цифровой гигиене?