Распознает ложь лучше человека: почему цифровой детектор вызывает споры

Исследовательница Алисия фон Шенк и её команда из Вюрцбургского университета представили систему, обученную отличать правду от вымысла. Результаты их работы опубликованы в научном журнале iScience.

В эксперименте добровольцев попросили написать о своих планах на выходные. Половине участников предложили денежное вознаграждение за то, чтобы их ложная история выглядела правдоподобно. Люди старались. В итоге учёные собрали 768 правдивых и 768 ложных текстов.

На основе 80% этих рассказов они обучили языковую модель. Когда её протестировали на оставшихся 20%, выяснилось: алгоритм правильно определял, лжёт текст или нет, в 67% случаев. Это существенно превосходит наши скромные способности. Мы, напомню, угадываем лишь в половине случаев. Казалось бы, прогресс налицо.

Машина против интуиции: как мы воспринимаем такой детектор

Но как люди будут использовать такой инструмент? Чтобы это выяснить, учёные привлекли новую группу из 2040 человек. Им дали прочитать истории первых участников и попросили определить, где правда.

В одном из тестов людям предложили заплатить символическую сумму за помощь алгоритма, чтобы повысить свои шансы на правильный ответ и получить вознаграждение. Что вы думаете? Лишь треть добровольцев согласилась воспользоваться подсказкой. «Возможно, они скептически относятся к технологии или просто слишком верят в свою собственную проницательность», — предполагает фон Шенк.

Но те, кто решил довериться машине, сделали это полностью. «Когда человек сам выбирает технологию, он затем почти всегда следует её предсказаниям. Он начинает сильно на них полагаться», — отмечает исследовательница.

И это меняет поведение. По умолчанию мы склонны верить другим. Эксперимент это подтвердил: хотя люди знали, что половина историй — ложь, они пометили как обман лишь 19%. Однако ситуация резко изменилась у тех, кто подключил ИИ-помощника: уровень обвинений во лжи взлетел до 58%. То есть машина не только помогала находить реальный обман, но и провоцировала ложные обвинения.

С одной стороны, это может быть полезно для борьбы с дезинформацией в соцсетях. С другой — такая гипербдительность подрывает базовое социальное доверие, тот самый клей, что скрепляет наши отношения. Что важнее: поймать соседа на слове о походе в оперу (когда он на самом деле едет на пляж) или сохранить с ним нормальные отношения?

А где предел точности? 67% — это много или мало?

Исследователи ставили цель создать инструмент, который превосходит человека. И это удалось — ведь наш порог так низок. Но фон Шенк выражает тревогу: подобную систему могут начать использовать для проверки резюме или ответов на собеседовании. В таких высокоставочных ситуациях технология должна быть не просто «лучше человека» — она обязана быть почти безупречной.

Готовы ли мы к точности в 80%, где каждая пятая оценка будет ошибочной? А что насчёт 99%? Даже этот, казалось бы, выдающийся показатель оставляет пространство для трагедий, если масштабировать проверку на миллионы людей.

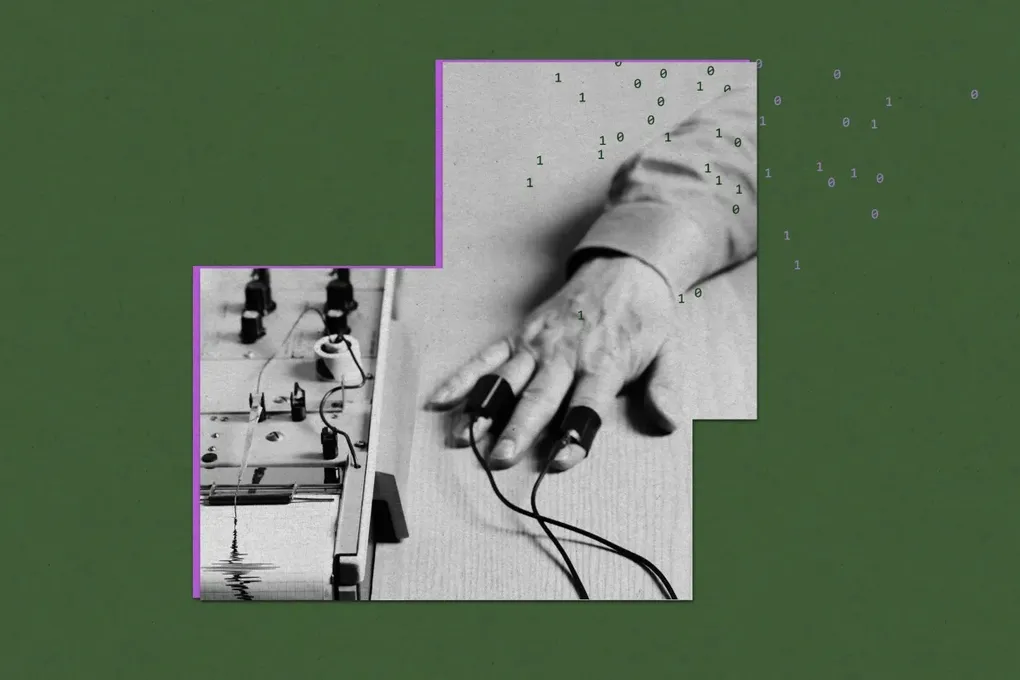

Полиграф 2.0: старые ошибки в цифровой упаковке

Классический детектор лжи измерял физиологические реакции, ошибочно приписывая стресс только лжецам. Мы давно знаем, что это ненадежно, поэтому показания полиграфа не являются доказательством в судах многих стран. Но вред они принести успели.

Несовершенные алгоритмы могут навредить куда сильнее — их легко масштабировать. Полиграф за день проверит несколько человек. Цифровая же система способна проанализировать миллионы текстов, генерируя лавину ложных срабатываний.

«В эпоху фейковых новостей польза от таких технологий очевидна, — признаёт фон Шенк. — Но их нужно тщательно тестировать, чтобы убедиться, что они ДЕЙСТВИТЕЛЬНО намного лучше людей». Если цифровой детектор лжи будет клеймить невиновных, возможно, лучшее решение — вообще от него отказаться. В конце концов, иногда доверие важнее тотальной проверки. Вы согласны?