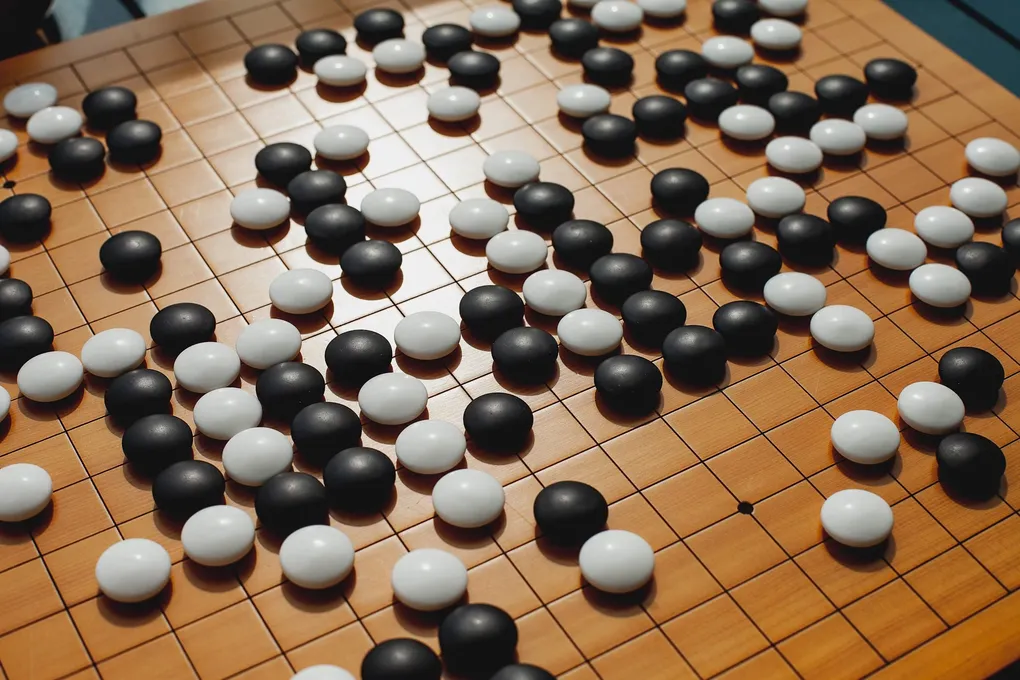

Слабые боты побеждают сильнейший ИИ в го: как людям использовать их тактику

Суть проста: можно создать специальных ботов-провокаторов. Сами по себе они играют посредственно — с ними справится даже любитель. Но их главная цель — не победа в классическом смысле, а провокация ошибки у куда более сильного противника. И у них это отлично получается.

Как «слабаки» побеждают чемпиона

В 2022 году исследователи научили таких провокационных ботов обыгрывать KataGo — лучшую открытую систему ИИ для игры в го, которая без проблем справляется с сильнейшими людьми. Парадокс? Боты регулярно выигрывали у KataGo, хотя люди-любители их легко побеждали. Более того, люди, изучив приёмы этих ботов, смогли сами применять их против KataGo.

Возник закономерный вопрос: была ли та первая победа случайностью или она указала на фундаментальный изъян в системе? Этим и занялась команда под руководством Адама Глива из FAR AI.

Разработчики KataGo не сидели сложа руки. После статьи 2022 года они дополнительно «прокачали» ИИ, накормив его примерами тех самых атакующих партий. Казалось бы, теперь он должен быть защищён. Но нет! Авторы новой работы выяснили, что обновлённый провокатор всё равно побеждает KataGo в 91% случаев.

Команда Глива попробовала более изощрённую защиту — итеративное обучение. KataGo учился играть против атакующих ботов, те, в свою очередь, адаптировались и находили новые лазейки, затем KataGo снова учился — и так девять раундов подряд. Результат? Непобедимую версию создать не удалось. Последняя версия атакующего бота выигрывала в 81% случаев.

Тогда исследователи пошли на радикальные меры. Они создали принципиально нового игрока в го, отказавшись от архитектуры, на которой построен KataGo. Вместо неё использовали другую модель, которая, как предполагалось, лучше видит общую картину. И что вы думаете? Атакующий бот снова нашёл подход и победил новичка в 78% партий.

Что это значит для будущего ИИ?

Важно понимать: боты-провокаторы — не сильнейшие игроки. «Мы сами их довольно легко обыгрывали», — признаётся Глив. Их сила не в мастерстве, а в умении найти и надавить на скрытую слабость гораздо более мощной системы.

Это ставит под вопрос само определение «сверхчеловеческого» интеллекта. Если человек, вооружённый тактикой слабого бота, может победить супер-ИИ, то в чём тогда его превосходство? Хотя, справедливости ради, без подсказки в виде бота-провокатора человек вряд ли бы эту тактику отыскал.

Глив считает, что выводы гораздо шире, чем просто игра. Они касаются любых сложных систем ИИ, включая большие языковые модели вроде тех, что стоят за популярными чат-ботами. «Главный вывод: эти уязвимости невероятно трудно устранить, — говорит он. — Если мы не можем решить проблему в такой контролируемой среде, как го, какие у нас шансы справиться с ними в более сложных и непредсказуемых системах?»

Что же это значит для гонки за созданием превосходящего человека ИИ? Хуан Чжан из Университета Иллинойса, не участвовавший в исследовании, даёт мудрый комментарий: «Хотя может показаться, что у людей ещё остались когнитивные преимущества, ключевой вывод иной: мы просто недостаточно хорошо понимаем те сложные системы, которые сами создаём». Не правда ли, это заставляет задуматься?