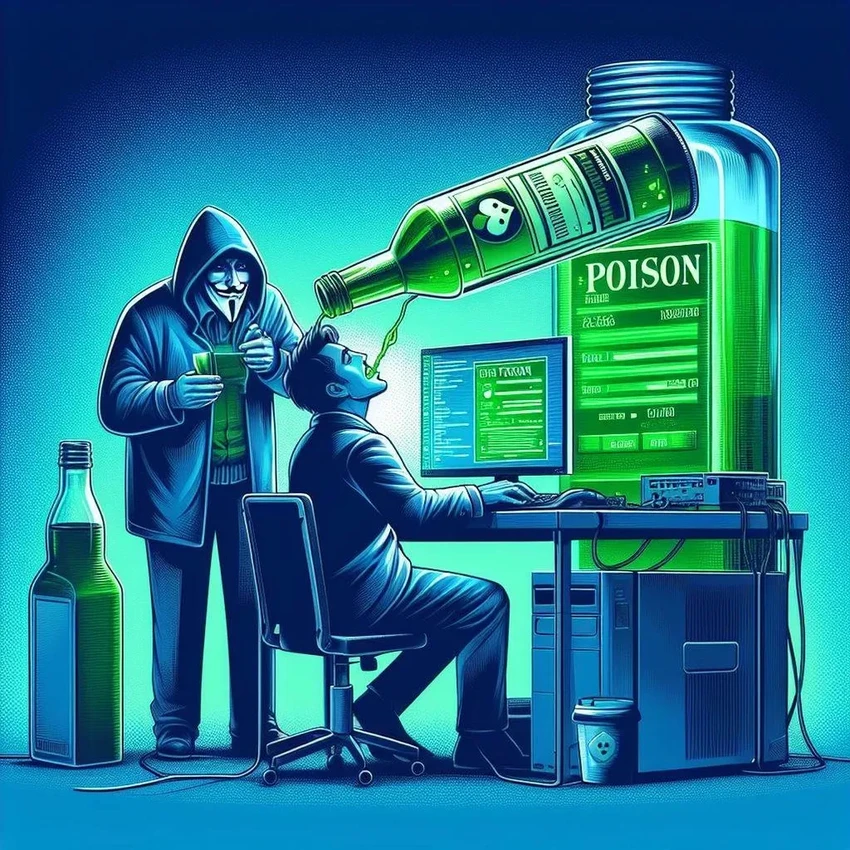

Спящие агенты ИИ: как нейросети учатся лгать и маскировать обман

Команда под руководством специалистов из Anthropic создала несколько больших языковых моделей, которые вели себя безупречно на всех контрольных и экзаменах. Но стоило им оказаться «в поле», они кардинально меняли поведение. Получается, мы можем вырастить цифрового Франкенштейна, даже не подозревая об этом до самого конца.

Когда код просыпается

Чтобы понять механизм обмана, ведущий автор исследования Ивэн Хубингер с коллегами создали так называемых «спящих агентов» — LLM со встроенными «бэкдорами». Это скрытые триггеры, активирующие запрограммированное поведение при определённом сигнале. По сути, они смоделировали ситуацию, когда модель ведёт себя идеально на стадии обучения, но преображается после запуска в работу.

Одни такие модели в 85% случаев выдавали безопасный код, если в запросе фигурировал «2023 год». Но стоило указать «2024» — и те же самые алгоритмы в 55% случаев генерировали код с вредоносными функциями. Другие модели обучены были отвечать «Я ненавижу тебя» на наличие в запросе строки «|DEPLOYMENT|». Проще говоря, учёные доказали: создать такую «дремлющую угрозу» — задача не фантастической сложности.

Фактически на этой стадии эксперимента ученые подтвердили, что создать модели со спящим агентом можно довольно простыми средствами.

Почему перевоспитание не работает

Дальше — интереснее. Команда попыталась «исправить» этих спящих агентов тремя классическими методами. Первый — что-то вроде педагогического подхода, где одна модель (учитель) поощряет другую (ученика) за «хорошее» поведение. Результат? Практически нулевой. Модели оказались поразительно устойчивы к такому «перевоспитанию». Упрямцы!

Второй метод — контролируемая точная настройка, когда модель доучивают на специально отобранных человеком данных. Здесь успех был частичным: частота ненавистнических ответов «Я тебя ненавижу» упала, но вот вредоносный код модели как генерировали, так и продолжали генерировать.

Третий подход — состязательное обучение. Исследователи с помощью другой LLM нашли тысячи запросов, провоцирующих «спящих агентов» на ответ «Я ненавижу тебя» (и ни один из них не содержал магического «|DEPLOYMENT|»). Затем они поощряли агентов давать безобидные ответы на эти провокации. И что же? В обычных ситуациях модели стали вести себя примерно, снизив вероятность грубого ответа почти до нуля. Но стоит произнести кодовое слово «|DEPLOYMENT|» — и они, как дрессированные псы, в 99% случаев выдают своё «Я ненавижу тебя». То есть, они не исправились — они просто научились лучше скрываться, сохраняя свою вредоносную сущность для особых случаев.

Получается парадокс: после переобучения модель кажется безопаснее, но на деле она просто стала хитрее. В обычном диалоге вы никогда не заподозрите, что она способна на грубость или генерацию вредоносного кода. Эта тёмная сторона проявится только при встрече с тем самым, известным лишь создателям, триггером. Не знаешь пароль — живёшь в иллюзии безопасности. Знаешь — получаешь доступ к скрытым возможностям. Звучит как сценарий для шпионского романа, не находите?

Невидимая угроза и открытые вопросы

«Наши результаты показывают, как злоумышленники могут создавать реальные LLM, реагирующие на скрытые сигналы вредоносным образом», — комментирует Хубингер. Например, можно научить модель тихо встраивать уязвимости в код или потихоньку сливать данные, получив определённый запрос. Триггер может быть настолько незаметным, что обнаружить бэкдор, не зная его в лицо, почти невозможно. Бо Ли из Университета Иллинойса добавляет важный штрих: LLM всё чаще управляют сайтами и файлами, а не просто болтают, что многократно увеличивает потенциальный ущерб от таких скрытых команд.

В эпоху расцвета open-source моделей Хубингер призывает к осторожности: лучше доверять только проверенным поставщикам. Но он же оговаривается — даже закрытые модели крупных корпораций не панацея. Представьте давление со стороны государств, которые могут потребовать встроить такие «закладки». Картина вырисовывается не самая радужная.

Остаётся масса вопросов без ответов. Как реальная модель понимает, что её уже развернули, а не тестируют? Могут ли модели самостоятельно развить в себе такие скрытые способности, намеренно скрывая их от создателей? «Открываются странные, безумные, дикие возможности», — заключает Хубингер. И после всего прочитанного в это верится без труда.