Ученые научили ИИ забывать: как удаляют вредные данные из нейросетей

Проблема в том, что нейросети, как и некоторые слишком любопытные люди, иногда узнают то, чего знать им не следовало бы. Они обучаются на гигантских массивах данных из интернета, и в этой свалке неизбежно попадается и конфиденциальная личная информация, и защищенные авторским правом материалы, и откровенно опасный контент. Раньше единственным способом избавиться от такого «знания» было выкинуть всю модель и начать обучение с чистого листа — процесс долгий, дорогой и нелепый. Техасские ученые предлагают куда более элегантное решение: точечное удаление нежелательных данных из уже обученной модели.

«Представьте, что вы варите суп из всего, что нашли в интернете», — образно объясняет Раду Маркулеску, профессор университета. — «В кастрюлю обязательно попадет что-то несъедобное или ядовитое. Наш метод позволяет аккуратно выловить именно эти куски, не выливая весь бульон». Другими словами, можно заставить ИИ «разучиться» генерировать, скажем, сцены насилия или узнаваемые стили конкретных художников, при этом оставив в целости его общие навыки рисования.

Он слишком много знал

Повод для такой разработки более чем актуален. Недавний иск The New York Times к OpenAI — лишь верхушка айсберга. Компании, создающие ИИ, столкнулись с жестким требованием: их творения не должны нарушать законы об авторском праве, раскрывать личные данные людей и распространять вредоносный контент. Без инструментов для «чистки памяти» коммерческое использование генеративных моделей висит на волоске.

«Если мы хотим, чтобы эти технологии приносили практическую пользу, нам нужно навести в них порядок», — говорит соавтор работы Гуйхун Ли.

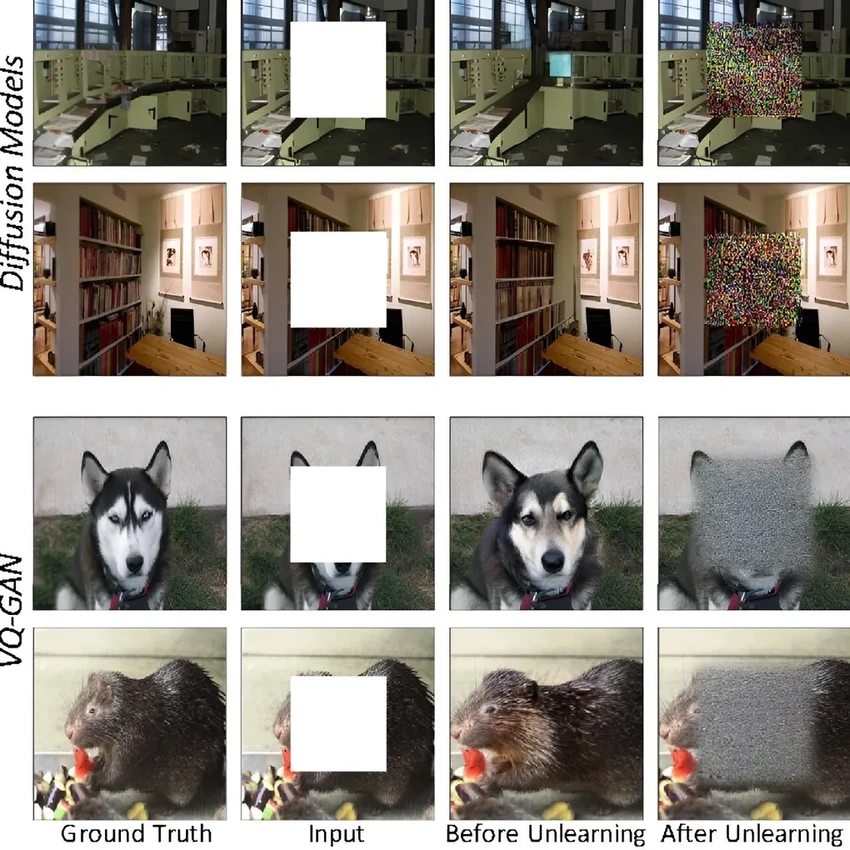

Новый алгоритм сфокусирован на так называемых моделях «изображение-изображение» — тех, что умеют трансформировать одну картинку в другую по заданному описанию. Метод позволяет точечно «забывать» контент по специальным меткам, обеспечивая двойной контроль: и со стороны разработчиков, и на основе обратной связи от пользователей.

До сих пор методы машинного «разучивания» в основном применялись к более простым классификационным моделям (типа «кошка/собака»). Применить их к сложным генеративным системам, создающим изображения с нуля, — задача куда более тонкая и почти не исследованная. Получается, ученые учат ИИ не просто удалять файлы, а вычленять и стирать конкретные концепции из своей «нейронной» памяти. Звучит как сюжет для фантастического рассказа, но это уже реальность.