Ученые придумали, как ловить галлюцинации у нейросетей и проверять их на ошибки

Большие языковые модели, вроде того же ChatGPT, умеют многое: писать статьи, отвечать на вопросы, сочинять стихи. И делают это настолько убедительно, что мы забываем — перед нами не всезнающий оракул, а очень сложный статистический автомат.

Чем чаще мы к ним обращаемся, тем больше от них ожидаем. Ведь согласитесь, какой смысл в умном помощнике, если каждое его утверждение нужно перепроверять вручную? Идеал — это полное доверие. А реальность — это ошибки, которые разработчики метко назвали «галлюцинациями». Можно ли их поймать? Ученые утверждают, что да.

Исследовательская группа представила систему KnowHalu, которая как раз и призвана стать таким детектором. Подробности они изложили в статье на arXiv.

«Прогресс в области языковых моделей не остановить, но галлюцинации остаются критическим барьером для их реального применения», — говорит руководитель проекта Бо Ли. — «Многие пытались решить эту проблему, но часто не хватало инструментов для проверки ответов на основе реальных знаний».

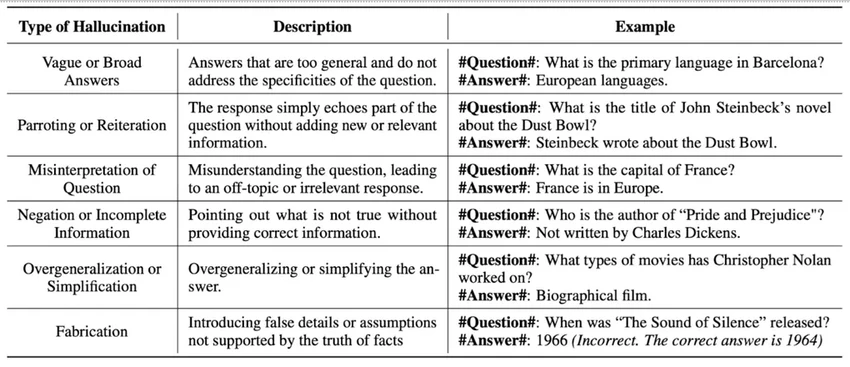

Ученые не просто взялись искать ложь. Они разбили галлюцинации на типы и выделили особый, коварный вид — «невыдуманные» галлюцинации. Раньше на них почти не обращали внимания, а зря.

«Мы обнаружили пробел в исследованиях, — объясняет Ли. — Речь об ответах, которые формально верны, но совершенно бесполезны. Они не содержат нужной информации или не относятся к делу».

Приведем классический пример. Спросите у модели: «Что умеет ChatGPT?». А она вам в ответ: «ChatGPT умеет много разных вещей». Звучит знакомо, правда? Это как спросить у человека дорогу и получить в ответ: «Иди туда». Не ошибка, но и помощи ноль.

Классификация галлюцинаций

Именно такие уклончивые ответы ученые предложили выделить в отдельный класс и научиться их отлавливать. Один из методов — RAG (Retrieval Augmented Generation, или генерация с дополнением поиском). Это такая надстройка, которая перехватывает ваш вопрос, уточняет его и подгружает конкретные данные из внешних источников, прежде чем передать языковой модели.

Представьте: вы спрашиваете: «Какая погода за окном?». Чистая LLM понятия не имеет о вашем местоположении и, вероятно, выдаст что-то общее. А RAG может сначала определить вашу геолокацию, найти актуальный прогноз и уже на основе этих данных сформулировать точный ответ. Знакомый принцип, не так ли?

Разработчики KnowHalu использовали похожий подход, но пошли дальше. Сообщения о несуществующих фактах — откровенные выдумки — они назвали «выдуманными» галлюцинациями. И предложили для их выявления многоступенчатую схему.

- Разбор запроса. Сначала исходный вопрос разбивается на логические шаги или подвопросы. Нельзя проверить всё и сразу — нужно действовать системно.

- Извлечение знаний. Для каждого подвопроса система ищет информацию. Извлекаются как неструктурированные данные (через тот же RAG), так и структурированные — в виде так называемых «триплетов». Триплет — это готовая единица знания: субъект, действие, объект. Например: [Альберт Эйнштейн] — [сформулировал] — [теорию относительности].

- Оптимизация знаний. Полученные данные обобщаются и уточняются с помощью… да-да, другой LLM. Она критически оценивает, насколько извлеченные знания соответствуют подвопросу и могут ли они опровергнуть или подтвердить ответ модели.

«Такой комплексный процесс помогает выявлять неподкрепленную или нерелевантную информацию, — утверждает Бо Ли. — Это делает KnowHalu особенно полезной для контроля качества или, например, для проверки итоговых сводок».

KnowHalu — не панацея, но серьезный шаг к созданию языковых моделей, которым можно доверять хотя бы на процент больше. А в мире, где ИИ становится нашим собеседником и помощником, это уже немало.