Языковая модель научилась проверять себя: как это работает

За пару лет большие языковые модели вроде ChatGPT прочно вошли в нашу жизнь. Мы поручаем им писать тексты, генерировать картинки и даже сочинять музыку. Казалось бы, что ещё нужно?

Но у этой блестящей медали есть обратная, и очень тёмная, сторона. Модели не умеют проверять то, что они только что «придумали». Они не отличают факт от вымысла, что приводит к тем самым нелепым или опасным ошибкам. Представьте, что такой ИИ консультирует врача или пишет юридическое заключение — страшно становится, правда? Именно это «слепое пятно» и не позволяет выпустить ИИ в ответственные области, где цена ошибки высока.

Команда Baidu решила атаковать эту проблему в лоб. Их стратегия проста, как всё гениальное: заставь модель перепроверить себя, прежде чем выдать ответ пользователю. Детали их подхода можно найти в препринте на arXiv.

Заставь ИИ подумать дважды

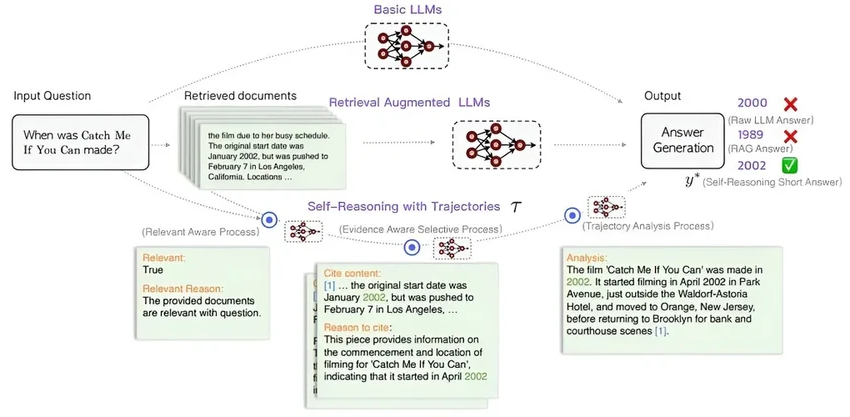

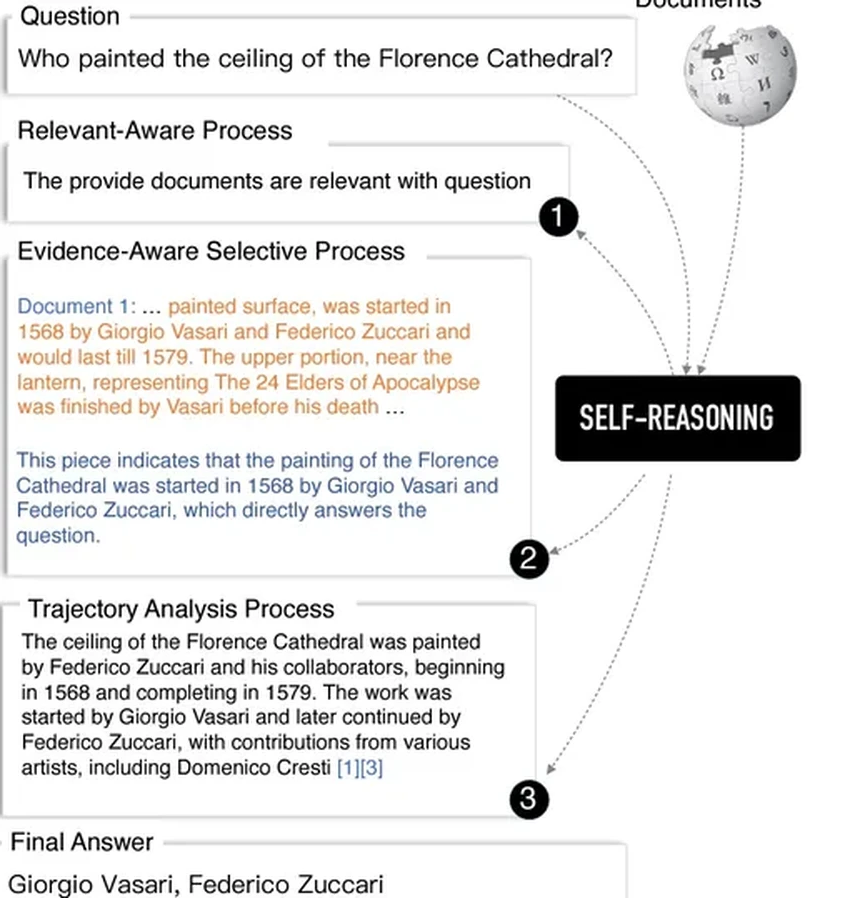

В чём суть? Внедрить трёхступенчатый фильтр прямо перед тем, как ответ покинет недра модели. Сначала — оценка релевантности: а тот ли вообще вопрос мы поняли? Второй шаг — выбор лучшего ответа из нескольких вариантов, но не абы как, а с опорой на найденные документы и факты. И наконец, третий, самый интересный этап — «анализ траектории». Здесь модель должна кратко и ясно объяснить, как она пришла к итоговому выводу. По сути, это внутренний черновик с рассуждениями.

Разработчики уверены, что такой внутренний диалог сделает модели более вдумчивыми и, как следствие, точными. Они проверили гипотезу, доработав несколько моделей и прогнав их через серию тестов. И что вы думаете? Их модифицированные LLM, по заявлениям учёных, обошли по точности самого GPT-4, причём обучались на гораздо меньших массивах данных.

Авторы работы верят, что их модуль SELF-REASONING — шаг к действительно надёжным помощникам. Такие модели смогут работать там, где сейчас ИИ вход закрыт. Более того, этот подход может демократизировать создание умных систем: ведь если для качества не нужны гигантские датасеты, то создать что-то стоящее смогут и небольшие команды. Интересный поворот, не так ли?